Forschungsmethoden, Studiendesign, Modelle, wissenschaftliches Publizieren

Forschungsmethoden, Studiendesign, Modelle, wissenschaftliches Publizieren

Biometrie: βίος = Leben, μέτρον = Maß(stab)

Biometrie: βίος = Leben, μέτρον = Maß(stab)| Forschung bedarf eines planvollen Vorgehens:

Definition des Problems, Literaturstudium, rational begründete

Hypothese, Studienplan, methodisch einwandfreies Vorgehen,

akkurates Datenmanagement, Evaluierung und Publikation der Ergebnisse. Wissenschaftlichkeit äußert sich u.a. in der Offenheit gegenüber Falsifikation, d.h. man vermeidet dogmatische Aussagen und stellt sich laufender Überprüfung. Hypothesen werden vorgeschlagen und überprüft, bessere Vorschläge ersetzen gegebenenfalls ihre Vorgänger - der Weg zu Erkenntnisgewinn. Logische (Computer-) oder materielle (mechanische) Modelle kommen zur Anwendung, wenn sie Vorteile gegenüber dem abgebildeten Original bieten: Leichter manipulierbar, verständlicher, finanzierbar, besser beobachtbar. Sie sollen prädiktiven oder erklärenden Wert haben und können zur Hypothesentestung eingesetzt werden. Das Experiment am realen lebenden Objekt können sie allerdings nicht immer ersetzen. Wissenschaftliche Publikationen sollen bestimmten Gütekriterien genügen: Klare Fragestellung und Zielsetzung, adäquates Studiendesign, zutreffende Methoden, ausreichende Zahl der Beobachtungen, geeignete biometrische Vorangsweise, klare Darstellung der Ergebnisse, angemessene Schlussfolgerungen und zitierte Literatur. Auch spielt die Zeitschrift oder das Medium, in der/dem die Studie veröffentlich wurde, eine wichtige Rolle: So weist der Impact Factor einer Zeitschrift auf ihre Akzeptanz und die Bedeutung hin, die ihr in der jeweiligen Community beigemessen wird. Originalpublikationen stellen neue Daten bzw. Verfahren vor; Übersichtsarbeiten (Reviews) fassen die Befunde aus Originalpublikationen zusammen. |

Publikationen: Qualität

Publikationen: Qualität  Studiendesign

Studiendesign  Wissenschaftliche Modelle

Wissenschaftliche Modelle

wissenschaftlicher Forschung.

wissenschaftlicher Forschung.

Abbildung: Der Weg von der Idee zur Veröffentlichung (und zurück)

Abbildung: Der Weg von der Idee zur Veröffentlichung (und zurück) Festmachen der Fragestellung, Definition des Problems (manch eine Studie scheitert daran, dass nicht klar ist, was eigentlich erforscht werden soll)

Festmachen der Fragestellung, Definition des Problems (manch eine Studie scheitert daran, dass nicht klar ist, was eigentlich erforscht werden soll) Rationaler Ausgangspunkt für die Fragestellung der betreffenden Studie (theoretische Grundlagen, Literaturstudium)

Rationaler Ausgangspunkt für die Fragestellung der betreffenden Studie (theoretische Grundlagen, Literaturstudium) Formulierung einer rational begründeten Hypothese (auf der Basis vorhandener Erkenntnisse)

Formulierung einer rational begründeten Hypothese (auf der Basis vorhandener Erkenntnisse)

Abschätzung der wahrscheinlich erfolgversprechenden Strategie

(Studienaufbau, Zahl und Art der notwendigen Beobachtungen / Messungen,

korrekte Messverfahren, bestmögliche statistische Beschreibung,

Bearbeitung und Interpretation)

Abschätzung der wahrscheinlich erfolgversprechenden Strategie

(Studienaufbau, Zahl und Art der notwendigen Beobachtungen / Messungen,

korrekte Messverfahren, bestmögliche statistische Beschreibung,

Bearbeitung und Interpretation) Absicherung in finanzieller (Projektbudget; Sponsoring?) und ethischer Hinsicht (Votum der Ethikkommission; Helsinki-Kriterien: Die Deklaration von Helsinki zu ethischen Grundsätzen für die medizinische Forschung am Menschen wurde 1964 von der 18. Generalversammlung des Weltärztebundes verabschiedet)

Absicherung in finanzieller (Projektbudget; Sponsoring?) und ethischer Hinsicht (Votum der Ethikkommission; Helsinki-Kriterien: Die Deklaration von Helsinki zu ethischen Grundsätzen für die medizinische Forschung am Menschen wurde 1964 von der 18. Generalversammlung des Weltärztebundes verabschiedet) Management der Projektdurchführung (Beschäftigung wissenschaftlich versierter MitarbeiterInnen: "Projektstellen")

Management der Projektdurchführung (Beschäftigung wissenschaftlich versierter MitarbeiterInnen: "Projektstellen") Sichtung, Bewertung und Darstellung der resultierenden Daten (Datenmanagement, Statistik)

Sichtung, Bewertung und Darstellung der resultierenden Daten (Datenmanagement, Statistik) Kritische Evaluierung der Ergebnisse (wurden die eingangs gestellten Fragen beantwortet? Gibt es Überraschungen?), Interpretation der Daten (was sagen diese aus?)

Kritische Evaluierung der Ergebnisse (wurden die eingangs gestellten Fragen beantwortet? Gibt es Überraschungen?), Interpretation der Daten (was sagen diese aus?) Adäquate Veröffentlichung (Publikation

Adäquate Veröffentlichung (Publikation  ) des Studienzwecks und -aufbaus, der Daten und Erkenntnisse, Reflexion vor dem Hintergrund bereits vorhandenen Wissens

) des Studienzwecks und -aufbaus, der Daten und Erkenntnisse, Reflexion vor dem Hintergrund bereits vorhandenen Wissens

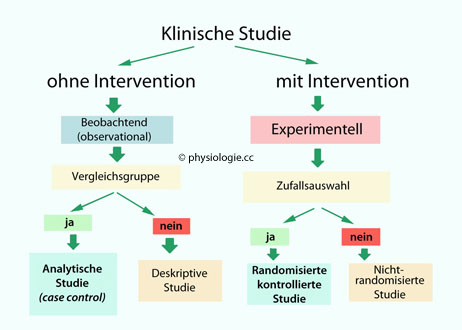

Abbildung: Klinisches Studiendesign

Abbildung: Klinisches Studiendesign

Prüfplan (Protocol) - was sind die Ziele der Studie? Wie sollen die Hypothesen geprüft werden? etc

Prüfplan (Protocol) - was sind die Ziele der Studie? Wie sollen die Hypothesen geprüft werden? etc Ethische Zulässigkeit - werden die Helsinki-Kriterien erfüllt? Können Probanden zu Schaden kommen, ist ihre Würde gewahrt? etc

Ethische Zulässigkeit - werden die Helsinki-Kriterien erfüllt? Können Probanden zu Schaden kommen, ist ihre Würde gewahrt? etc Auswahl der Probanden, Art und Größe der Stichproben (Statistische Voraus-Abschätzungen)

Auswahl der Probanden, Art und Größe der Stichproben (Statistische Voraus-Abschätzungen)

Randomisierung - Selektionseffekte durch (unbewusste) Schieflage (bias) bei der Definition der Stichproben werden vermieden

Randomisierung - Selektionseffekte durch (unbewusste) Schieflage (bias) bei der Definition der Stichproben werden vermieden Verblindung - z.B. double blind,

weder Proband noch Untersucher wissen, ob z.B. ein Placebo oder ein

Verum zum Einsatz kommen, Selbsttäuschungseffekte werden vermieden

Verblindung - z.B. double blind,

weder Proband noch Untersucher wissen, ob z.B. ein Placebo oder ein

Verum zum Einsatz kommen, Selbsttäuschungseffekte werden vermieden Festlegung der zu messenden Zustandsvariablen und Messmethoden (sind diese durchführbar, finanzierbar, für die Fragestellung aussagekräftig, möglichst risiko- und schmerzfrei ...?)

Festlegung der zu messenden Zustandsvariablen und Messmethoden (sind diese durchführbar, finanzierbar, für die Fragestellung aussagekräftig, möglichst risiko- und schmerzfrei ...?) Datenauswertung - ist klar, wie mit den Daten zu verfahren ist?

Datenauswertung - ist klar, wie mit den Daten zu verfahren ist?

Abbildung: Nicht jede Idee ist von hohem wissenschaftlichem Rang

Abbildung: Nicht jede Idee ist von hohem wissenschaftlichem Rang

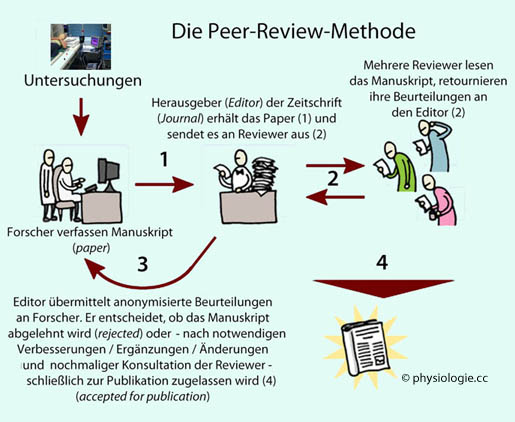

Das

Peer-Review-Verfahren (s. unten) benötigt dann meist mehrere Monate,

Kritik der Begutachter muss aufgenommen und im Text entsprechend

berücksichtigt (oder fundiert widerlegt) werden; im Fall einer

Zurückweisung definiert man die weitere Vorgangsweise (Weiterführung,

Vertiefung oder Abänderung der Untersuchungsstrategie, Suche nach einem

anderen Forum etc).

Das

Peer-Review-Verfahren (s. unten) benötigt dann meist mehrere Monate,

Kritik der Begutachter muss aufgenommen und im Text entsprechend

berücksichtigt (oder fundiert widerlegt) werden; im Fall einer

Zurückweisung definiert man die weitere Vorgangsweise (Weiterführung,

Vertiefung oder Abänderung der Untersuchungsstrategie, Suche nach einem

anderen Forum etc).

Frage: Woher kommt das Wissen, auf dem wir die Logik medizinischer - diagnostischer, therapeutischer, kurativer, prophylaktischer - Maßnahmen aufbauen? Wie gelangt die Heilkunde zu besseren, humaneren, verlässlicheren, schmerzfreieren Methoden und Handlungen? Woher kommt der Fortschritt in der Medizin?

Antwort: Aus planvollen Untersuchungen unter Anwendung wissenschaftlicher Methoden. Dabei gilt das Prinzip der Offenheit (Nachvollziehbarkeit) und Disziplin (Beachtung aller nötigen Regeln).

Die Ergebnisse

solcher Studien werden in wissenschaftlichen Zeitschriften veröffentlicht (publiziert). Wie beurteilt man deren Qualität?

Dazu wurde vom Institute for Scientific

Information (ISI) in Philadelphia der 'Impact Factor' (IF)

Dazu wurde vom Institute for Scientific

Information (ISI) in Philadelphia der 'Impact Factor' (IF)

eingeführt. Er ist einer von mehreren Maßzahlen, welche Eigenschaften

wissenschaftlicher Publikationsforen quantifizieren; dazu gehört u.a.

auch die Nachhaltigkeit, mit der Publikationen zitiert werden, die in

einem solchen Organ veröffentlich wurden (citation half-life

- 'Altern' der Information, in Analogie zum radioaktiven Zerfall als

'Halbwertszeit' bezeichnet: die Zeit, nach der die Zitierfrequenz auf

die Hälfte ihres anfänglichen Wertes absinkt).

eingeführt. Er ist einer von mehreren Maßzahlen, welche Eigenschaften

wissenschaftlicher Publikationsforen quantifizieren; dazu gehört u.a.

auch die Nachhaltigkeit, mit der Publikationen zitiert werden, die in

einem solchen Organ veröffentlich wurden (citation half-life

- 'Altern' der Information, in Analogie zum radioaktiven Zerfall als

'Halbwertszeit' bezeichnet: die Zeit, nach der die Zitierfrequenz auf

die Hälfte ihres anfänglichen Wertes absinkt).

Der IF einer Zeitschrift 'Z' für das Jahr 'Y' gibt

an, wie oft durchschnittlich in einem bestimmten Jahr Y Publikationen genannt wurden,

die in den beiden vorausgegangenen Jahren in Z erschienen sind. Jedes Jahr wird für jede (erfasste) Zeitschrift ein neuer IF

berechnet. Zeitschriften,

deren Arbeiten - aus welchen Gründen

auch immer - oft zitiert werden, erhalten hohe Impactfaktoren. (Über

die Qualität einzelner Arbeiten sagt der IF direkt nichts aus.)

Der IF einer Zeitschrift 'Z' für das Jahr 'Y' gibt

an, wie oft durchschnittlich in einem bestimmten Jahr Y Publikationen genannt wurden,

die in den beiden vorausgegangenen Jahren in Z erschienen sind. Jedes Jahr wird für jede (erfasste) Zeitschrift ein neuer IF

berechnet. Zeitschriften,

deren Arbeiten - aus welchen Gründen

auch immer - oft zitiert werden, erhalten hohe Impactfaktoren. (Über

die Qualität einzelner Arbeiten sagt der IF direkt nichts aus.)

Abbildung) ist ein Qualitätsfilter,

der dem Leser garantiert, dass die Publikation bereits eine mehrfache

strenge Fachprüfung 'überstanden' hat, bevor sie publik gemacht

wird - ein grundsätzlicher Sicherheitsfaktor.

Abbildung) ist ein Qualitätsfilter,

der dem Leser garantiert, dass die Publikation bereits eine mehrfache

strenge Fachprüfung 'überstanden' hat, bevor sie publik gemacht

wird - ein grundsätzlicher Sicherheitsfaktor.Der IF hängt

also direkt mit dem Qualitätsanspruch des wissenschaftlichen Beirates

zusammen. Ein hoher IF steigert das Renommee der Zeitschrift, und so entsteht

ein Wettlauf der Autoren, in dieser Zeitschrift zu publizieren.

Der IF der Zeitschrift, in der eine Publikation erschienen ist, ist nur ein

Maßstab unter mehreren. Unterschiedliche Fachgebiete (Disziplinen) sind durch unterschiedliche mittlere Häufigkeiten an

Einzelpublikationen (pro Autor) und Impactfaktorhöhen charakterisiert.

So ist etwa ein direkter IF-Vergleich z.B. aus dem Bereich

Molekularbiologie (viele Zitierungen, typisch hohe IF) mit einem spezialisierten

klinischen Fach (z.B. Hals-Nasen-Ohrenheilkunde - wenige Zeitschriften, geringere Zitationshäufigkeit) nicht sinnvoll.

Wichtig bleibt, Publikationen aufmerksam zu lesen und von Fall zu Fall zu bewerten (Kriterien s. unten), um eine individuelle Entscheidung zu treffen, was sie zu einer konkreten Fragestellung beitragen können.

Um

festzustellen, wie glaubhaft und/oder relevant die Ergebnisse und

Behauptungen in einer Publikation sind, gibt es eine Reihe von

Maßstäben:

Um

festzustellen, wie glaubhaft und/oder relevant die Ergebnisse und

Behauptungen in einer Publikation sind, gibt es eine Reihe von

Maßstäben:

Ist eine klare Fragestellung und Zielsetzung erkennbar?

Ist eine klare Fragestellung und Zielsetzung erkennbar?

Wird der Aufbau der Studie den Zielsetzungen

gerecht? (Studiendesign)

Wird der Aufbau der Studie den Zielsetzungen

gerecht? (Studiendesign)

Sind die verwendeten Methoden und Maßnahmen adäquat, eindeutig und ausreichend

dargestellt?

Sind die verwendeten Methoden und Maßnahmen adäquat, eindeutig und ausreichend

dargestellt?

Welche statistischen Verfahren wurden

angewandt? (Biometrie)

Welche statistischen Verfahren wurden

angewandt? (Biometrie)

Sind die Ergebnisse klar und ausreichend dargestellt?

Sind die Ergebnisse klar und ausreichend dargestellt?

Werden angemessene Schlussfolgerungen gezogen?

Werden angemessene Schlussfolgerungen gezogen?

Ist die zitierte Literatur adäquat und ausreichend?

Ist die zitierte Literatur adäquat und ausreichend?

In welcher Zeitschrift ist die Arbeit erschienen?

In welcher Zeitschrift ist die Arbeit erschienen?

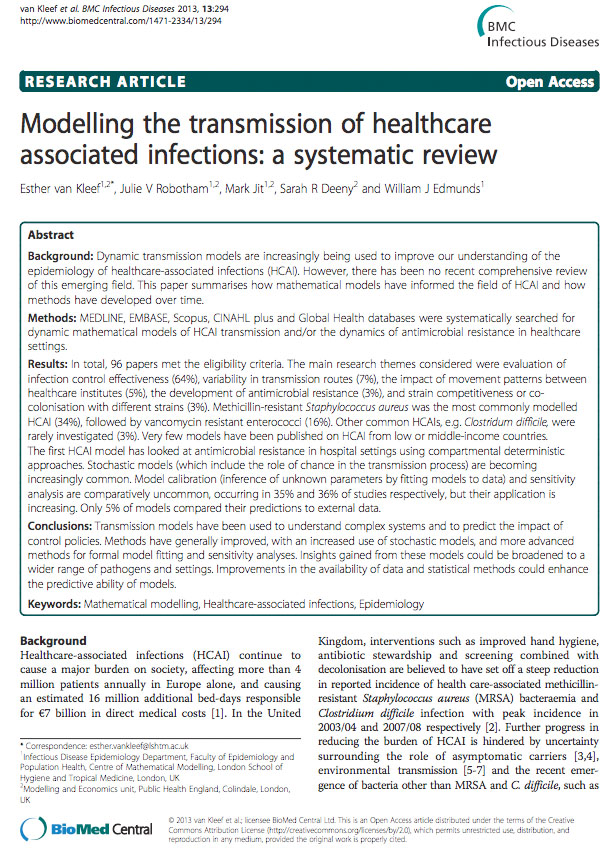

Abbildung: Beispiel einer Originalpublikation

Abbildung: Beispiel einer Originalpublikation

Titel der Publikation (title): Kurz, prägnant

Titel der Publikation (title): Kurz, prägnant Autoren (Namen, Institutionen, Adressen, genaue Kontaktdaten des corresponding author)

Autoren (Namen, Institutionen, Adressen, genaue Kontaktdaten des corresponding author) Zusammenfassung (abstract) mit Zitierdaten (Zeitschrift, Jahrgang, Band-Nr, Seitenzahlen) und Stichworten (key terms)

Zusammenfassung (abstract) mit Zitierdaten (Zeitschrift, Jahrgang, Band-Nr, Seitenzahlen) und Stichworten (key terms) Einleitung (background / introduction): Der Leser wird in das Thema "hineingezogen"

Einleitung (background / introduction): Der Leser wird in das Thema "hineingezogen" Methodenteil (procedures, methods, data management / statistics, Studiendesign) - über methodische Fehlerquellen bei der Vermessung von Blutproben

Methodenteil (procedures, methods, data management / statistics, Studiendesign) - über methodische Fehlerquellen bei der Vermessung von Blutproben  s. dort

s. dort Ergebnisteil (results):

Darstellung der gefundenen Daten, übersichtlich organisiert. Meistens

ist es von Vorteil, die wichtigsten Daten in Form von Tabellen (tables)

darzustellen. Dabei sollen Pseudogenauigkeiten vermieden werden (z.B.

Angabe von Mittelwerten auf mehr Stellen als die Meßgenauigkeit hergibt)

Ergebnisteil (results):

Darstellung der gefundenen Daten, übersichtlich organisiert. Meistens

ist es von Vorteil, die wichtigsten Daten in Form von Tabellen (tables)

darzustellen. Dabei sollen Pseudogenauigkeiten vermieden werden (z.B.

Angabe von Mittelwerten auf mehr Stellen als die Meßgenauigkeit hergibt) Besprechung (discussion) mit Eingrenzung / Gültigkeitsbereich (limitations), Schlussfolgerungen (conclusions), Ausblick (perspectives): Der "philosophische" Teil

Besprechung (discussion) mit Eingrenzung / Gültigkeitsbereich (limitations), Schlussfolgerungen (conclusions), Ausblick (perspectives): Der "philosophische" Teil In der Arbeit zitierte wissenschaftliche Literatur

In der Arbeit zitierte wissenschaftliche Literatur  (references): Einheitlich formatiert, in der Reihenfolge der Erwähnung im Text oder alphabetisch nach den Namen der Erstautoren

(references): Einheitlich formatiert, in der Reihenfolge der Erwähnung im Text oder alphabetisch nach den Namen der Erstautoren Eine wichtige Rolle spielen auch Abbildungen (figures):

Sie zeigen z.B. Versuchsanordnungen, fassen Daten in übersichtlicher

Form zusammen und geben eine Übersicht über Muster und Zeitverläufe,

die mit Text alleine nicht zu vermitteln wären.

Eine wichtige Rolle spielen auch Abbildungen (figures):

Sie zeigen z.B. Versuchsanordnungen, fassen Daten in übersichtlicher

Form zusammen und geben eine Übersicht über Muster und Zeitverläufe,

die mit Text alleine nicht zu vermitteln wären.

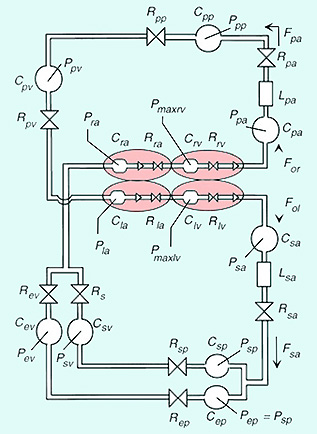

Abbildung: Hydrodynamisches Kreislaufmodell

Abbildung: Hydrodynamisches Kreislaufmodell F = Strömung

F = Strömung  p = Druck

p = Druck  R = Widerstand

R = Widerstand

durchzuführen. Modelle sind Abbildungen von Vorgängen (physiologische Modelle; z.B. Modell der Blutdruckentstehung) oder Gegenständen.

Sie bilden Teilaspekte der Realität ab, auf die es in einem bestimmten

Zusammenhang ankommt.

durchzuführen. Modelle sind Abbildungen von Vorgängen (physiologische Modelle; z.B. Modell der Blutdruckentstehung) oder Gegenständen.

Sie bilden Teilaspekte der Realität ab, auf die es in einem bestimmten

Zusammenhang ankommt. Für die

medizinische Forschung ist die Verwendung von Modellen

oft unverzichtbar. Modelle benützt man aus praktischen Gründen:

Modellkonstrukte sind leichter manipulierbar, durchschaubar, finanzierbar, beobachtbar,

oder haben andere Vorteile gegenüber dem abgebildeten Original.

Modellkonstrukte sind leichter manipulierbar, durchschaubar, finanzierbar, beobachtbar,

oder haben andere Vorteile gegenüber dem abgebildeten Original.

Sie sollen prädiktiven Wert haben, also das Verhalten realer

Systeme befriedigend voraussagen (z.B. Wetterprognose).

Sie sollen prädiktiven Wert haben, also das Verhalten realer

Systeme befriedigend voraussagen (z.B. Wetterprognose).

Sie können

zur Überprüfung von Hypothesen eingesetzt werden,

oder zur Entdeckung oder Erklärung von Naturphänomenen (Forschungsmodelle).

Sie können

zur Überprüfung von Hypothesen eingesetzt werden,

oder zur Entdeckung oder Erklärung von Naturphänomenen (Forschungsmodelle).

Ihrer Natur nach gibt es

logische (z.B. Computerprogramme) und

logische (z.B. Computerprogramme) und materielle Modelle (z.B. mechanisches Kreislaufmodell).

materielle Modelle (z.B. mechanisches Kreislaufmodell).

theoretische

theoretische  Modelle,

die auf der Basis vorhandenen Wissens über das modellierte Original

konstruiert werden, erklärende Aufgaben erfüllen und Voraussagen

über das Systemverhalten erlauben sollen in Situationen, die

einer direkten Untersuchung nicht zugänglich sind; und

Modelle,

die auf der Basis vorhandenen Wissens über das modellierte Original

konstruiert werden, erklärende Aufgaben erfüllen und Voraussagen

über das Systemverhalten erlauben sollen in Situationen, die

einer direkten Untersuchung nicht zugänglich sind; und  empirische

empirische  Modelle ('black-box-Modelle'),

die nicht von Systemeigenschaften ausgehen, sondern von der Struktur

der vorgefundenen Systemvariablen (z.B. Kurvenanpassung oder

Regressivmodelle).

Modelle ('black-box-Modelle'),

die nicht von Systemeigenschaften ausgehen, sondern von der Struktur

der vorgefundenen Systemvariablen (z.B. Kurvenanpassung oder

Regressivmodelle).

Zur Validierung

des Modells werden experimentelle und Simulationsergebnisse verglichen und

möglichst in Übereinstimmung gebracht. Schrittweise wird die mindestens

nötige Komplexität der Modellstruktur identifiziert, und die Beträge

der verwendeten Modellparameter werden feinjustiert.

Zur Validierung

des Modells werden experimentelle und Simulationsergebnisse verglichen und

möglichst in Übereinstimmung gebracht. Schrittweise wird die mindestens

nötige Komplexität der Modellstruktur identifiziert, und die Beträge

der verwendeten Modellparameter werden feinjustiert.

Kein Modell repräsentiert das Original in allen seinen Eigenschaften. So können Fragen, für deren Beantwortung kein befriedigendes Modell existiert (etwa weil man über das reale System zu wenig weiß bzw. dieses zu komplex funktioniert), nur durch Untersuchung des 'Originals' beantwortet werden (z.B. Untersuchung am realen biologischen System statt 'Alternativmethode' wie Computersimulation oder In-vitro-Versuch). Die Untersuchung hochkomplexer Systeme (wie Organismen, Menschen) erfordert die Anwendung biometrischer Prinzipien und ein entsprechendes Studiendesign.

Naturwissenschaftliche Forschungspläne enthalten folgende Anteile:

Definition von Fragestellung und Problem; Literaturstudium;

Hypothesenerstellung; Festlegung von Studienaufbau, Zahl und Art der

notwendigen Beobachtungen, Messverfahren; Plan für die statistische Beschreibung,

Bearbeitung und Interpretation der anfallenden Daten; finanzielle und ethische

Absicherung der Vorgangsweise; Projektdurchführung; Datenmanagement, Statistik,

Interpretation der Daten; Verfassen einer Publikation (Studienzweck

und -aufbau, Daten und Erkenntnisse, Reflexion vor dem Hintergrund

bereits vorhandenen Wissens, belegt mit Zitaten); Einsenden an

wissenschaftliche Zeitschrift; Reaktion auf die Kritik der Begutachter;

Veröffentlichung Naturwissenschaftliche Forschungspläne enthalten folgende Anteile:

Definition von Fragestellung und Problem; Literaturstudium;

Hypothesenerstellung; Festlegung von Studienaufbau, Zahl und Art der

notwendigen Beobachtungen, Messverfahren; Plan für die statistische Beschreibung,

Bearbeitung und Interpretation der anfallenden Daten; finanzielle und ethische

Absicherung der Vorgangsweise; Projektdurchführung; Datenmanagement, Statistik,

Interpretation der Daten; Verfassen einer Publikation (Studienzweck

und -aufbau, Daten und Erkenntnisse, Reflexion vor dem Hintergrund

bereits vorhandenen Wissens, belegt mit Zitaten); Einsenden an

wissenschaftliche Zeitschrift; Reaktion auf die Kritik der Begutachter;

Veröffentlichung  Beobachtungsstudien (analytisch oder deskriptiv) bedürfen keiner Intervention, Interventionsstudien

sollten nach Möglichkeit Randomisierungen enthalten. Kontrollgruppen

erhalten z.B. ein Placebo, Verumgruppen die Behandlung, deren Wirkung

getestet werden soll. Bei Doppelblindstudien wissen weder Proband noch Untersucher, ob im Einzelfall Placebo oder Verum zum Einsatz kommt. Die

Gruppen der Untersuchten müssen möglichst gleichmäßig zusammengesetzt

sein (Alter, Geschlecht, Gesundheitszustand etc). Unabhängige Variable

werden vom Untersucher beeinflusst (z.B. die Dosis

einer Hormongabe), abhängige Variable werden gemessen, um die Reaktion

auf die Manipulation der unabhängigen Variablen zu verfolgen (z.B.

Effekt

der verschiedenen Dosierungen) Beobachtungsstudien (analytisch oder deskriptiv) bedürfen keiner Intervention, Interventionsstudien

sollten nach Möglichkeit Randomisierungen enthalten. Kontrollgruppen

erhalten z.B. ein Placebo, Verumgruppen die Behandlung, deren Wirkung

getestet werden soll. Bei Doppelblindstudien wissen weder Proband noch Untersucher, ob im Einzelfall Placebo oder Verum zum Einsatz kommt. Die

Gruppen der Untersuchten müssen möglichst gleichmäßig zusammengesetzt

sein (Alter, Geschlecht, Gesundheitszustand etc). Unabhängige Variable

werden vom Untersucher beeinflusst (z.B. die Dosis

einer Hormongabe), abhängige Variable werden gemessen, um die Reaktion

auf die Manipulation der unabhängigen Variablen zu verfolgen (z.B.

Effekt

der verschiedenen Dosierungen) Um die

Bedeutung einer Publikation zur beurteilen, kann man sich am Rang der

Zeitschrift orientieren, in der diese erschienen ist. Der Impact Factor (IF) ist eine solche Maßzahl: Sie

gibt sie an, wie oft durchschnittlich in einem bestimmten Jahr

Publikationen genannt wurden, die in den zwei vorausgegangenen Jahren

in der betreffenden Zeitschrift erschienen sind. Jedes Jahr wird für

die Zeitschrift ein neuer IF berechnet. Zeitschriften, deren Arbeiten

oft zitiert werden, erhalten hohe Impactfaktoren - typischerweise weil für die Beurteilung und Annahme von

Publikationen besonders strenge Maßstäbe angelegt werden. Das

Review-Verfahren ist ein Qualitätsfilter und Sicherheitsfaktor: Publikationen haben

mehrfache hochqualifizierte Fachprüfungen überstanden, bevor sie publik gemacht werden. Die citation half-life ist die Zeit, nach der die Zitierfrequenz auf die Hälfte ihres anfänglichen Wertes absinkt - sie gibt die Nachhaltigkeit an, mit der Publikationen dieses Organs zitiert werden ('Altern' der Information) Um die

Bedeutung einer Publikation zur beurteilen, kann man sich am Rang der

Zeitschrift orientieren, in der diese erschienen ist. Der Impact Factor (IF) ist eine solche Maßzahl: Sie

gibt sie an, wie oft durchschnittlich in einem bestimmten Jahr

Publikationen genannt wurden, die in den zwei vorausgegangenen Jahren

in der betreffenden Zeitschrift erschienen sind. Jedes Jahr wird für

die Zeitschrift ein neuer IF berechnet. Zeitschriften, deren Arbeiten

oft zitiert werden, erhalten hohe Impactfaktoren - typischerweise weil für die Beurteilung und Annahme von

Publikationen besonders strenge Maßstäbe angelegt werden. Das

Review-Verfahren ist ein Qualitätsfilter und Sicherheitsfaktor: Publikationen haben

mehrfache hochqualifizierte Fachprüfungen überstanden, bevor sie publik gemacht werden. Die citation half-life ist die Zeit, nach der die Zitierfrequenz auf die Hälfte ihres anfänglichen Wertes absinkt - sie gibt die Nachhaltigkeit an, mit der Publikationen dieses Organs zitiert werden ('Altern' der Information)  Wissenschaftliche

Modelle werden erstellt, wenn ethische, organisatorische oder andere

Gründe eine direkte Untersuchung des Problems an einem realen System

ausschließen. Sie sind

leichter manipulierbar, durchschaubar, finanzierbar, beobachtbar, oder

haben andere Vorteile gegenüber dem abgebildeten Original. Solche Modelle bilden

Teilaspekte der Realität ab, auf die es im gegebenen

Zusammenhang ankommt, lassen Hypothesen überprüfen und sollten

prädiktiven Wert haben. Man

unterscheidet logische (z.B. Computerprogramm) und materielle

(mechanisches Modell), theoretische (experimentelle Untersuchung nicht

möglich) und empirische Modelle (z.B. Kurvenanpassung). Experimentelle

und

Simulationsergebnisse sollten möglichst übereinstimmen (Validierung).

Ein Modell soll so einfach wie möglich, so komplex wie nötig

sein (Optimierung) Wissenschaftliche

Modelle werden erstellt, wenn ethische, organisatorische oder andere

Gründe eine direkte Untersuchung des Problems an einem realen System

ausschließen. Sie sind

leichter manipulierbar, durchschaubar, finanzierbar, beobachtbar, oder

haben andere Vorteile gegenüber dem abgebildeten Original. Solche Modelle bilden

Teilaspekte der Realität ab, auf die es im gegebenen

Zusammenhang ankommt, lassen Hypothesen überprüfen und sollten

prädiktiven Wert haben. Man

unterscheidet logische (z.B. Computerprogramm) und materielle

(mechanisches Modell), theoretische (experimentelle Untersuchung nicht

möglich) und empirische Modelle (z.B. Kurvenanpassung). Experimentelle

und

Simulationsergebnisse sollten möglichst übereinstimmen (Validierung).

Ein Modell soll so einfach wie möglich, so komplex wie nötig

sein (Optimierung) |